protecciones ampliadas para niños anuncia apple

agosto 9, 2021

¡URL copiada!

En Apple, nuestro objetivo es crear tecnología que empodere a las personas y enriquezca sus vidas, al mismo tiempo que las ayuda a mantenerse seguras. Queremos ayudar a proteger a los niños de los depredadores que utilizan herramientas de comunicación para reclutarlos y explotarlos, y limitar la propagación del material de abuso sexual infantil (MASI).

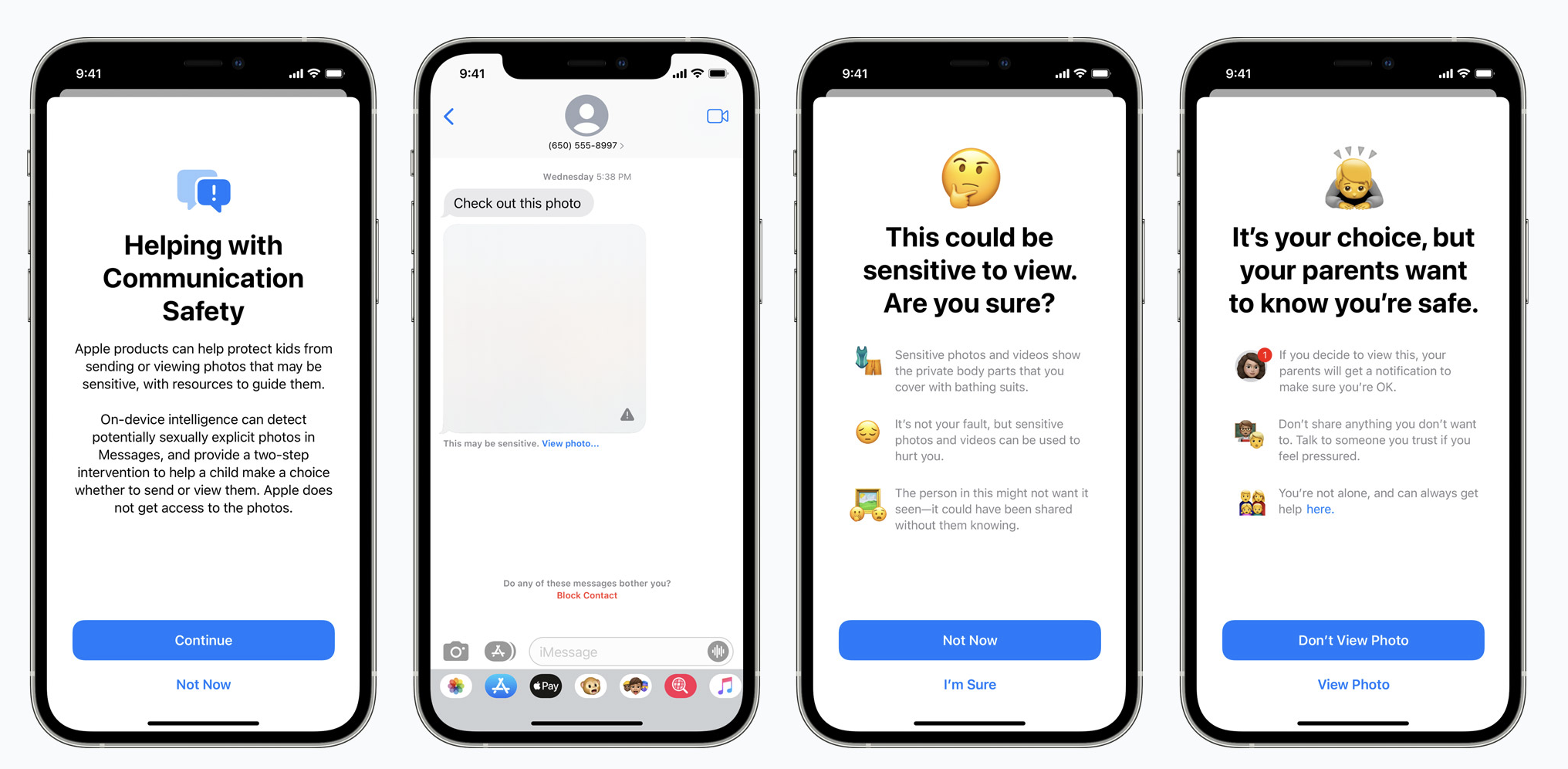

Apple está introduciendo nuevas funciones de seguridad infantil en tres áreas, desarrolladas en colaboración con expertos en seguridad infantil. En primer lugar, las nuevas herramientas de comunicación permitirán a los padres desempeñar un papel más informado para ayudar a sus hijos a navegar la comunicación en línea. La aplicación Mensajes utilizará el aprendizaje automático en el dispositivo para advertir sobre contenido sensible, mientras que Apple mantiene las comunicaciones privadas ilegibles.

A continuación, iOS y iPadOS utilizarán nuevas aplicaciones de criptografía para ayudar a limitar la propagación de CSAM en línea, mientras se diseña para la privacidad del usuario. La detección de CSAM ayudará a Apple a proporcionar información valiosa a las fuerzas del orden sobre las colecciones de CSAM en Fotos de iCloud.

Por último, las actualizaciones de Siri y Search brindan a padres e hijos información ampliada y ayuda en caso de que se encuentren en situaciones inseguras. Siri y Search también intervendrán cuando los usuarios intenten buscar temas relacionados con CSAM.

Estas características llegarán a finales de este año en actualizaciones para iOS 15, iPadOS 15, watchOS 8 y macOS Monterey. *

Este programa es ambicioso y proteger a los niños es una responsabilidad importante. Estos esfuerzos evolucionarán y se expandirán con el tiempo.

Seguridad de la comunicación en Mensajes

La aplicación Mensajes agregará nuevas herramientas para advertir a los niños y a sus padres cuando reciban o envíen fotos sexualmente explícitas.

Al recibir este tipo de contenido, la foto se verá borrosa y se advertirá al niño, se le presentarán recursos útiles y se le asegurará que está bien si no quiere ver esta foto. Como precaución adicional, también se le puede decir al niño que, para asegurarse de que está seguro, sus padres recibirán un mensaje si lo ven. Existen protecciones similares disponibles si un niño intenta enviar fotos sexualmente explícitas. El niño será advertido antes de que se envíe la foto y los padres pueden recibir un mensaje si el niño decide enviarlo.

Messages utiliza el aprendizaje automático en el dispositivo para analizar los archivos adjuntos de imágenes y determinar si una foto es sexualmente explícita. La función está diseñada para que Apple no tenga acceso a los mensajes.

Esta función se actualizará a finales de este año para las cuentas configuradas como familias en iCloud para iOS 15, iPadOS 15 y macOS Monterey.

Detección de CSAM

Otra preocupación importante es la difusión de material sobre abuso sexual infantil (MASI) en línea. CSAM se refiere al contenido que representa actividades sexualmente explícitas que involucran a un niño.

Para ayudar a abordar esto, la nueva tecnología en iOS y iPadOS * permitirá a Apple detectar imágenes CSAM conocidas almacenadas en iCloud Photos. Esto permitirá a Apple reportar estos casos al Centro Nacional para Niños Desaparecidos y Explotados (NCMEC). El NCMEC actúa como un centro de informes integral para CSAM y trabaja en colaboración con las agencias de aplicación de la ley en los Estados Unidos.

El método de Apple para detectar CSAM conocido está diseñado teniendo en cuenta la privacidad del usuario. En lugar de escanear imágenes en la nube, el sistema realiza una comparación en el dispositivo utilizando una base de datos de hashes de imágenes CSAM conocidos proporcionados por NCMEC y otras organizaciones de seguridad infantil. Apple transforma aún más esta base de datos en un conjunto ilegible de hash que se almacena de forma segura en los dispositivos de los usuarios.

Antes de que una imagen se almacene en Fotos de iCloud, se realiza un proceso de comparación en el dispositivo para esa imagen con los hash CSAM conocidos. Este proceso de coincidencia está impulsado por una tecnología criptográfica llamada intersección de conjuntos privados, que determina si hay una coincidencia sin revelar el resultado. El dispositivo crea un vale de seguridad criptográfico que codifica el resultado de la coincidencia junto con datos encriptados adicionales sobre la imagen. Este cupón se carga en Fotos de iCloud junto con la imagen.

Utilizando otra tecnología llamada umbral para compartir secretos, el sistema garantiza que Apple no pueda interpretar el contenido de los vales de seguridad a menos que la cuenta de iCloud Photos cruce un umbral de contenido CSAM conocido. El umbral está establecido para proporcionar un nivel de precisión extremadamente alto y garantiza menos de uno en un billón de posibilidades por año de marcar incorrectamente una cuenta determinada.

Solo cuando se excede el umbral, la tecnología criptográfica permite a Apple interpretar el contenido de los vales de seguridad asociados con las imágenes CSAM coincidentes. Luego, Apple revisa manualmente cada informe para confirmar que hay una coincidencia, deshabilita la cuenta del usuario y envía un informe al NCMEC. Si un usuario siente que su cuenta ha sido marcada por error, puede presentar una apelación para que se restablezca su cuenta.

Esta nueva e innovadora tecnología permite a Apple proporcionar información valiosa y procesable al NCMEC y a la policía con respecto a la proliferación de CSAM conocido. Y lo hace al tiempo que proporciona importantes beneficios de privacidad sobre las técnicas existentes, ya que Apple solo se entera de las fotos de los usuarios si tienen una colección de CSAM conocido en su cuenta de Fotos de iCloud. Incluso en estos casos, Apple solo aprende sobre imágenes que coinciden con CSAM conocido.

Ampliación de la guía en Siri y Búsqueda

Apple también está ampliando la orientación en Siri y Search al proporcionar recursos adicionales para ayudar a los niños y padres a mantenerse seguros en línea y obtener ayuda en situaciones inseguras. Por ejemplo, los usuarios que le pregunten a Siri cómo pueden denunciar el abuso sexual infantil o infantil o la explotación infantil serán dirigidos a recursos sobre dónde y cómo presentar una denuncia.

Siri y Search también se están actualizando para intervenir cuando los usuarios realizan búsquedas de consultas relacionadas con CSAM. Estas intervenciones explicarán a los usuarios que el interés en este tema es dañino y problemático, y proporcionarán recursos de los socios para obtener ayuda con este tema.

Estas actualizaciones de Siri y Search llegarán a finales de este año en una actualización de iOS 15, iPadOS 15, watchOS 8 y macOS Monterey.

Más información

Hemos proporcionado más información sobre estas características en los documentos a continuación, incluidos resúmenes técnicos, pruebas y evaluaciones independientes del sistema de detección CSAM de expertos en criptografía y aprendizaje automático.

- Protecciones ampliadas para niños: preguntas frecuentes (PDF)

- Protecciones ampliadas para niños - Resumen de tecnología (PDF)

- Detección de CSAM - Resumen técnico (PDF)

- Sistema PSI de Apple: análisis y protocolo de seguridad (PDF)

- Evaluación técnica de la detección de CSAM - Benny Pinkas (PDF)

- Evaluación técnica de la detección de CSAM - David Forsyth (PDF)

- Evaluación técnica de la detección de CSAM - Mihir Bellare (PDF)

- Prueba de seguridad alternativa del sistema PSI de Apple - Mihir Bellare (PDF)